Подредена двойка (X, Y) от случайни променливи X и Y се нарича двумерна случайна променлива или случаен вектор в двумерно пространство. Двумерна случайна променлива (X, Y) се нарича още система от случайни променливи X и Y. Наборът от всички възможни стойности на дискретна случайна променлива с техните вероятности се нарича закон за разпределение на тази случайна променлива. Дискретна двумерна случайна променлива (X, Y) се счита за дадена, ако е известен нейният закон за разпределение:

P(X=x i, Y=y j) = p ij, i=1,2...,n, j=1,2...,m

Цел на услугата. Използвайки услугата, съгласно даден закон за разпространение, можете да намерите:

- разпределителни серии X и Y, очаквана стойност M[X], M[Y], дисперсия D[X], D[Y];

- ковариация cov(x,y), коефициент на корелация r x,y, условна серия на разпределение X, условно очакване M;

Инструкции. Посочете размерността на матрицата на вероятностното разпределение (брой редове и колони) и нейния тип. Полученото решение се записва във файл на Word.

Пример №1. Двумерна дискретна случайна променлива има таблица на разпределение:

| Y/X | 1 | 2 | 3 | 4 |

| 10 | 0 | 0,11 | 0,12 | 0,03 |

| 20 | 0 | 0,13 | 0,09 | 0,02 |

| 30 | 0,02 | 0,11 | 0,08 | 0,01 |

| 40 | 0,03 | 0,11 | 0,05 | р |

Решение. Стойността на q намираме от условието Σp ij = 1

Σp ij = 0,02 + 0,03 + 0,11 + … + 0,03 + 0,02 + 0,01 + q = 1

0,91+q = 1. Откъде идва q = 0,09?

Използвайки формулата ∑P(x аз,г й) = p аз(j=1..n), намираме серията на разпределение X.

M[y] = 1*0,05 + 2*0,46 + 3*0,34 + 4*0,15 = 2,59

Дисперсия D[Y] = 1 2 *0.05 + 2 2 *0.46 + 3 2 *0.34 + 4 2 *0.15 - 2.59 2 = 0.64

Стандартно отклонениеσ(y) = sqrt(D[Y]) = sqrt(0,64) = 0,801

Ковариация cov(X,Y) = M - M[X] M[Y] = 2 10 0,11 + 3 10 0,12 + 4 10 0,03 + 2 20 0,13 + 3 20 0,09 + 4 ·20·0,02 + 1·30·0,02 + 2·30·0,11 + 3·30·0,08 + 4·30·0,01 + 1·40·0,03 + 2·40·0,11 + 3·40·0,05 + 4·40 ·0,09 - 25,2 · 2,59 = -0,068

Коефициент на корелация r xy = cov(x,y)/σ(x)&sigma(y) = -0,068/(11,531*0,801) = -0,00736

Пример 2. Данни статистическа обработкаинформация относно два показателя X и Y са отразени в корелационната таблица. Задължително:

- напишете серии на разпределение за X и Y и изчислете примерни средни стойности и примерни стандартни отклонения за тях;

- напишете условни серии на разпределение Y/x и изчислете условни средни Y/x;

- изобразяват графично зависимостта на условните средни Y/x от X стойностите;

- изчислете примерния коефициент на корелация Y върху X;

- напишете примерно уравнение за предна регресия;

- изобразете данните от корелационната таблица геометрично и изградете регресионна линия.

Наборът от всички възможни стойности на дискретна случайна променлива с техните вероятности се нарича закон за разпределение на тази случайна променлива.

Дискретна двумерна случайна променлива (X,Y) се счита за дадена, ако е известен нейният закон за разпределение:

P(X=x i, Y=y j) = p ij, i=1,2...,n, j=1,2..,m

| X/Y | 20 | 30 | 40 | 50 | 60 |

| 11 | 2 | 0 | 0 | 0 | 0 |

| 16 | 4 | 6 | 0 | 0 | 0 |

| 21 | 0 | 3 | 6 | 2 | 0 |

| 26 | 0 | 0 | 45 | 8 | 4 |

| 31 | 0 | 0 | 4 | 6 | 7 |

| 36 | 0 | 0 | 0 | 0 | 3 |

1. Зависимост на случайните величини X и Y.

Намерете сериите на разпределение X и Y.

Използвайки формулата ∑P(x аз,г й) = p аз(j=1..n), намираме серията на разпределение X.

| х | 11 | 16 | 21 | 26 | 31 | 36 | |

| П | 2 | 10 | 11 | 57 | 17 | 3 | ∑P i = 100 |

M[x] = (11*2 + 16*10 + 21*11 + 26*57 + 31*17 + 36*3)/100 = 25,3

Дисперсия D[X].

D[X] = (11 2 *2 + 16 2 *10 + 21 2 *11 + 26 2 *57 + 31 2 *17 + 36 2 *3)/100 - 25,3 2 = 24,01

Стандартно отклонение σ(x).

Използвайки формулата ∑P(x аз,г й) = q й(i=1..m), намираме серията на разпределение Y.

| Y | 20 | 30 | 40 | 50 | 60 | |

| П | 6 | 9 | 55 | 16 | 14 | ∑P i = 100 |

M[y] = (20*6 + 30*9 + 40*55 + 50*16 + 60*14)/100 = 42,3

Дисперсия D[Y].

D[Y] = (20 2 *6 + 30 2 *9 + 40 2 *55 + 50 2 *16 + 60 2 *14)/100 - 42,3 2 = 99,71

Стандартно отклонение σ(y).

Тъй като P(X=11,Y=20) = 2≠2 6, тогава случайните променливи X и Y зависим.

2. Закон за условно разпределение X.

Закон за условно разпределение X(Y=20).

P(X=11/Y=20) = 2/6 = 0,33

P(X=16/Y=20) = 4/6 = 0,67

P(X=21/Y=20) = 0/6 = 0

P(X=26/Y=20) = 0/6 = 0

P(X=31/Y=20) = 0/6 = 0

P(X=36/Y=20) = 0/6 = 0

Условно математическо очакване M = 11*0,33 + 16*0,67 + 21*0 + 26*0 + 31*0 + 36*0 = 14,33

Условна дисперсия D = 11 2 *0,33 + 16 2 *0,67 + 21 2 *0 + 26 2 *0 + 31 2 *0 + 36 2 *0 - 14,33 2 = 5,56

Закон за условно разпределение X(Y=30).

P(X=11/Y=30) = 0/9 = 0

P(X=16/Y=30) = 6/9 = 0,67

P(X=21/Y=30) = 3/9 = 0,33

P(X=26/Y=30) = 0/9 = 0

P(X=31/Y=30) = 0/9 = 0

P(X=36/Y=30) = 0/9 = 0

Условно математическо очакване M = 11*0 + 16*0,67 + 21*0,33 + 26*0 + 31*0 + 36*0 = 17,67

Условна дисперсия D = 11 2 *0 + 16 2 *0,67 + 21 2 *0,33 + 26 2 *0 + 31 2 *0 + 36 2 *0 - 17,67 2 = 5,56

Закон за условно разпределение X(Y=40).

P(X=11/Y=40) = 0/55 = 0

P(X=16/Y=40) = 0/55 = 0

P(X=21/Y=40) = 6/55 = 0,11

P(X=26/Y=40) = 45/55 = 0,82

P(X=31/Y=40) = 4/55 = 0,0727

P(X=36/Y=40) = 0/55 = 0

Условно математическо очакване M = 11*0 + 16*0 + 21*0,11 + 26*0,82 + 31*0,0727 + 36*0 = 25,82

Условна дисперсия D = 11 2 *0 + 16 2 *0 + 21 2 *0,11 + 26 2 *0,82 + 31 2 *0,0727 + 36 2 *0 - 25,82 2 = 4,51

Закон за условно разпределение X(Y=50).

P(X=11/Y=50) = 0/16 = 0

P(X=16/Y=50) = 0/16 = 0

P(X=21/Y=50) = 2/16 = 0,13

P(X=26/Y=50) = 8/16 = 0,5

P(X=31/Y=50) = 6/16 = 0,38

P(X=36/Y=50) = 0/16 = 0

Условно математическо очакване M = 11*0 + 16*0 + 21*0,13 + 26*0,5 + 31*0,38 + 36*0 = 27,25

Условна дисперсия D = 11 2 *0 + 16 2 *0 + 21 2 *0,13 + 26 2 *0,5 + 31 2 *0,38 + 36 2 *0 - 27,25 2 = 10,94

Закон за условно разпределение X(Y=60).

P(X=11/Y=60) = 0/14 = 0

P(X=16/Y=60) = 0/14 = 0

P(X=21/Y=60) = 0/14 = 0

P(X=26/Y=60) = 4/14 = 0,29

P(X=31/Y=60) = 7/14 = 0,5

P(X=36/Y=60) = 3/14 = 0,21

Условно математическо очакване M = 11*0 + 16*0 + 21*0 + 26*0,29 + 31*0,5 + 36*0,21 = 30,64

Условна дисперсия D = 11 2 *0 + 16 2 *0 + 21 2 *0 + 26 2 *0,29 + 31 2 *0,5 + 36 2 *0,21 - 30,64 2 = 12,37

3. Закон за условно разпределение Y.

Закон за условно разпределение Y(X=11).

P(Y=20/X=11) = 2/2 = 1

P(Y=30/X=11) = 0/2 = 0

P(Y=40/X=11) = 0/2 = 0

P(Y=50/X=11) = 0/2 = 0

P(Y=60/X=11) = 0/2 = 0

Условно математическо очакване M = 20*1 + 30*0 + 40*0 + 50*0 + 60*0 = 20

Условна дисперсия D = 20 2 *1 + 30 2 *0 + 40 2 *0 + 50 2 *0 + 60 2 *0 - 20 2 = 0

Закон за условно разпределение Y(X=16).

P(Y=20/X=16) = 4/10 = 0,4

P(Y=30/X=16) = 6/10 = 0,6

P(Y=40/X=16) = 0/10 = 0

P(Y=50/X=16) = 0/10 = 0

P(Y=60/X=16) = 0/10 = 0

Условно математическо очакване M = 20*0,4 + 30*0,6 + 40*0 + 50*0 + 60*0 = 26

Условна дисперсия D = 20 2 *0,4 + 30 2 *0,6 + 40 2 *0 + 50 2 *0 + 60 2 *0 - 26 2 = 24

Закон за условно разпределение Y(X=21).

P(Y=20/X=21) = 0/11 = 0

P(Y=30/X=21) = 3/11 = 0,27

P(Y=40/X=21) = 6/11 = 0,55

P(Y=50/X=21) = 2/11 = 0,18

P(Y=60/X=21) = 0/11 = 0

Условно математическо очакване M = 20*0 + 30*0,27 + 40*0,55 + 50*0,18 + 60*0 = 39,09

Условна дисперсия D = 20 2 *0 + 30 2 *0,27 + 40 2 *0,55 + 50 2 *0,18 + 60 2 *0 - 39,09 2 = 44,63

Закон за условно разпределение Y(X=26).

P(Y=20/X=26) = 0/57 = 0

P(Y=30/X=26) = 0/57 = 0

P(Y=40/X=26) = 45/57 = 0,79

P(Y=50/X=26) = 8/57 = 0,14

P(Y=60/X=26) = 4/57 = 0,0702

Условно математическо очакване M = 20*0 + 30*0 + 40*0,79 + 50*0,14 + 60*0,0702 = 42,81

Условна дисперсия D = 20 2 *0 + 30 2 *0 + 40 2 *0,79 + 50 2 *0,14 + 60 2 *0,0702 - 42,81 2 = 34,23

Закон за условно разпределение Y(X=31).

P(Y=20/X=31) = 0/17 = 0

P(Y=30/X=31) = 0/17 = 0

P(Y=40/X=31) = 4/17 = 0,24

P(Y=50/X=31) = 6/17 = 0,35

P(Y=60/X=31) = 7/17 = 0,41

Условно математическо очакване M = 20*0 + 30*0 + 40*0,24 + 50*0,35 + 60*0,41 = 51,76

Условна дисперсия D = 20 2 *0 + 30 2 *0 + 40 2 *0,24 + 50 2 *0,35 + 60 2 *0,41 - 51,76 2 = 61,59

Закон за условно разпределение Y(X=36).

P(Y=20/X=36) = 0/3 = 0

P(Y=30/X=36) = 0/3 = 0

P(Y=40/X=36) = 0/3 = 0

P(Y=50/X=36) = 0/3 = 0

P(Y=60/X=36) = 3/3 = 1

Условно математическо очакване M = 20*0 + 30*0 + 40*0 + 50*0 + 60*1 = 60

Условна дисперсия D = 20 2 *0 + 30 2 *0 + 40 2 *0 + 50 2 *0 + 60 2 *1 - 60 2 = 0

Ковариация.

cov(X,Y) = M - M[X]·M[Y]

cov(X,Y) = (20 11 2 + 20 16 4 + 30 16 6 + 30 21 3 + 40 21 6 + 50 21 2 + 40 26 45 + 50 26 8 + 60 26 4 + 40 31 4 + 50 31 6 + 60 31 7 + 60 36 3)/100 - 25,3 42,3 = 38,11

Ако случайните променливи са независими, тогава тяхната ковариация е нула. В нашия случай cov(X,Y) ≠ 0.

Коефициент на корелация.

Уравнението на линейната регресия от y до x е:

Уравнението на линейната регресия от x към y е:

Нека намерим необходимите числени характеристики.

Примерни средни стойности:

x = (20(2 + 4) + 30(6 + 3) + 40(6 + 45 + 4) + 50(2 + 8 + 6) + 60(4 + 7 + 3))/100 = 42,3

y = (20(2 + 4) + 30(6 + 3) + 40(6 + 45 + 4) + 50(2 + 8 + 6) + 60(4 + 7 + 3))/100 = 25,3

Разлики:

σ 2 x = (20 2 (2 + 4) + 30 2 (6 + 3) + 40 2 (6 + 45 + 4) + 50 2 (2 + 8 + 6) + 60 2 (4 + 7 + 3) )/100 - 42,3 2 = 99,71

σ 2 y = (11 2 (2) + 16 2 (4 + 6) + 21 2 (3 + 6 + 2) + 26 2 (45 + 8 + 4) + 31 2 (4 + 6 + 7) + 36 2 (3))/100 - 25,3 2 = 24,01

Откъде получаваме стандартни отклонения:

σ x = 9,99 и σ y = 4,9

и ковариация:

Cov(x,y) = (20 11 2 + 20 16 4 + 30 16 6 + 30 21 3 + 40 21 6 + 50 21 2 + 40 26 45 + 50 26 8 + 60 26 4 + 40 31 4 + 50 31 6 + 60 31 7 + 60 36 3)/100 - 42,3 25,3 = 38,11

Нека да определим коефициента на корелация:

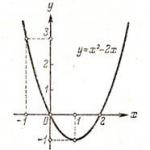

Нека напишем уравненията на регресионните линии y(x):

и изчислявайки, получаваме:

y x = 0,38 x + 9,14

Нека запишем уравненията на регресионните линии x(y):

и изчислявайки, получаваме:

x y = 1,59 y + 2,15

Ако нанесем точките, определени от таблицата и регресионните линии, ще видим, че и двете линии минават през точката с координати (42.3; 25.3) и точките са разположени близо до регресионните линии.

Значение на коефициента на корелация.

Използвайки таблицата на Стюдънт с ниво на значимост α=0,05 и степени на свобода k=100-m-1 = 98, намираме t crit:

t crit (n-m-1;α/2) = (98;0,025) = 1,984

където m = 1 е броят на обяснителните променливи.

Ако t наблюдавано > t критично, тогава получената стойност на корелационния коефициент се счита за значима (нулевата хипотеза, според която корелационният коефициент е равен на нула, се отхвърля).

Тъй като t obs > t crit, ние отхвърляме хипотезата, че коефициентът на корелация е равен на 0. С други думи, коефициентът на корелация е статистически значим.

Упражнение. Броят на ударите на двойки стойности на случайни променливи X и Y в съответните интервали е даден в таблицата. Използвайки тези данни, намерете примерния коефициент на корелация и примерните уравнения на прави регресионни линии на Y върху X и X върху Y.

Решение

Пример. Вероятностното разпределение на двумерна случайна променлива (X, Y) е дадено от таблица. Намерете законите на разпределение на компонентните величини X, Y и корелационния коефициент p(X, Y).

Изтеглете решение

Упражнение. Двуизмерен дискретно количество(X, Y) се дава от закона за разпределение. Намерете законите на разпределение на компонентите X и Y, ковариацията и коефициента на корелация.

Условни закони на разпределение. Регресия.

Определение. Условният закон на разпределение на един от едномерните компоненти на двумерна случайна променлива (X, Y) е неговият закон на разпределение, изчислен при условие, че другият компонент е приел определена стойност (или е попаднал в някакъв интервал). В предишната лекция разгледахме намирането на условни разпределения за дискретни случайни променливи. Там са дадени и формули за условни вероятности:

В случай на непрекъснати случайни променливи е необходимо да се определят плътностите на вероятностите на условните разпределения j y (x) и j X (y). За целта в дадените формули заместваме вероятностите на събитията с техните “елементи на вероятност”!

след намаляване с dx и dy получаваме:

![]()

тези. условната плътност на вероятността на един от едномерните компоненти на двумерна случайна променлива е равна на отношението на нейната съвместна плътност към плътността на вероятността на другия компонент. Тези отношения са записани във формата

се наричат теорема (правило) за умножаване на плътностите на разпределението.

Условни плътности j y (x) и j X (y). имат всички свойства на „безусловната“ плътност.

При изследване на двумерни случайни величини се разглеждат числените характеристики на едномерните компоненти X и Y – математически очаквания и дисперсии. За непрекъсната случайна променлива (X, Y) те се определят по формулите:

Наред с тях се разглеждат и числените характеристики на условните разпределения: условните математически очаквания M x (Y) и M y (X) и условните дисперсии D x (Y) и D Y (X). Тези характеристики се намират с помощта на обичайните формули за математическо очакване и дисперсия, в които се използват условни вероятности или условни плътности на вероятности вместо вероятности за събития или плътности на вероятности.

Условно математическо очакване на случайна величина Y при X = x, т.е. M x (Y) е функция на x, наречена регресионна функция или просто регресия на Y върху X. По подобен начин M Y (X) се нарича регресионна функция или просто регресия на X върху Y. Графиките на тези функции са наречени регресионни линии (или регресионни криви) Y съответно по X или X по Y.

Зависими и независими случайни променливи.

Определение.Случайните променливи X и Y се наричат независими, ако тяхната съвместна функция на разпределение F(x,y) е представена като произведение на функциите на разпределение F 1 (x) и F 2 (y) на тези случайни променливи, т.е.

![]()

В противен случай случайните променливи X и Y се наричат зависими.

Диференцирайки два пъти равенството по отношение на аргументите x и y, получаваме

![]()

тези. за независими непрекъснати случайни променливи X и Y, тяхната обща плътност j(x,y) е равна на произведението на плътностите на вероятностите j 1 (x) и j 2 (y) на тези случайни променливи.

Досега се сблъскахме с концепцията за функционална връзка между променливите X и Y, когато всяка стойност x на една променлива съответства на строго определена стойност на другата. Например връзката между две случайни променливи - броят на отказалите части от оборудването за определен период от време и тяхната цена - е функционална.

Като цяло те се сблъскват с различен тип зависимост, по-лека от функционалната.

Определение.Връзката между две случайни променливи се нарича вероятностна (стохастична или статистическа), ако всяка стойност на една от тях съответства на определено (условно) разпределение на другата.

В случай на вероятностна (стохастична) зависимост е невъзможно, знаейки стойността на една от тях, да определите точно стойността на другата, но можете само да посочите разпределението на другото количество. Например връзката между броя на повредите на оборудването и разходите за превантивните му ремонти, теглото и височината на човек, времето, прекарано на ученик в гледане на телевизионни програми и четене на книги и др. са вероятностни (стохастични).

На фиг. Фигура 5.10 показва примери на зависими и независими случайни променливи X и Y.

Когато изучавате системи от случайни променливи, винаги трябва да обръщате внимание на степента и характера на тяхната зависимост. Тази зависимост може да бъде повече или по-слабо изразена, повече или по-малко тясна. В някои случаи връзката между случайните променливи може да бъде толкова близка, че като знаете стойността на една случайна променлива, можете точно да посочите стойността на друга. В другия краен случай зависимостта между случайните величини е толкова слаба и далечна, че практически могат да се считат за независими.

Концепцията за независими случайни променливи е една от важните концепции на теорията на вероятностите.

Казва се, че случайна променлива е независима от случайна променлива, ако законът за разпределение на променливата не зависи от това каква стойност приема променливата.

За непрекъснати случайни променливи условието за независимост от може да бъде записано като:

![]()

по всяко .

Напротив, ако зависи от , тогава

![]() .

.

Нека докажем, че зависимостта или независимостта на случайните променливи винаги е взаимна: ако стойността не зависи от .

Наистина, нека не зависи от:

![]() . (8.5.1)

. (8.5.1)

От формули (8.4.4) и (8.4.5) имаме:

откъдето, като вземем предвид (8.5.1), получаваме:

![]()

Q.E.D.

Тъй като зависимостта и независимостта на случайните променливи винаги са взаимни, можем да дадем нова дефиниция на независими случайни променливи.

Случайните променливи се наричат независими, ако законът за разпределение на всяка от тях не зависи от стойността на другата. В противен случай количествата се наричат зависими.

За независими непрекъснати случайни променливи теоремата за умножение за законите на разпределението приема формата:

![]() , (8.5.2)

, (8.5.2)

тоест плътността на разпределение на система от независими случайни променливи е равна на произведението на плътностите на разпределение на отделните променливи, включени в системата.

Условието (8.5.2) може да се разглежда като необходимо и достатъчно условие за независимостта на случайните величини.

Често по самата форма на функцията може да се заключи, че случайните променливи са независими, а именно, ако плътността на разпределението се разложи на произведението на две функции, едната от които зависи само от, другата само от, тогава случайните променливи са независими.

Пример. Плътността на разпределение на системата има формата:

.

.

Определете дали случайните променливи и са зависими или независими.

Решение. Разлагайки знаменателя на множители, имаме:

.

.

От факта, че функцията се разделя на произведението на две функции, едната от които зависи само от , а другата само от , заключаваме, че количествата и трябва да са независими. Действително, прилагайки формули (8.4.2) и (8.4.3), имаме:

;

;

по същия начин

,

,

как можем да сме сигурни, че

![]()

и следователно количествата и са независими.

Горният критерий за преценка на зависимостта или независимостта на случайните променливи се основава на предположението, че законът за разпределение на системата ни е известен. На практика по-често се случва обратното: законът за разпределение на системата не е известен; Известни са само законите на разпределение на отделните количества, включени в системата, и има основание да се смята, че количествата са независими. Тогава можем да напишем плътността на разпределение на системата като произведение на плътностите на разпределение на отделните количества, включени в системата.

Нека се спрем по-подробно на важните понятия „зависимост“ и „независимост“ на случайните променливи.

Концепцията за „независимост“ на случайните променливи, която използваме в теорията на вероятностите, е малко по-различна от обичайната концепция за „зависимост“ на променливите, която използваме в математиката. Наистина, обикновено под „зависимост“ на количествата имаме предвид само един вид зависимост - пълна, твърда, така наречената функционална зависимост. Две количества се наричат функционално зависими, ако, знаейки стойността на едно от тях, можете точно да посочите стойността на другото.

В теорията на вероятностите се сблъскваме с друг, по-общ вид зависимост - вероятностна или "стохастична" зависимост. Ако дадено количество е свързано с количество чрез вероятностна зависимост, тогава, знаейки стойността на , е невъзможно да се посочи точната стойност на , а може да се посочи само неговият закон на разпределение, който зависи от това каква стойност е приела величината.

Вероятностната връзка може да бъде повече или по-малко тясна; С увеличаване на стегнатостта на вероятностната зависимост тя става все по-близо до функционалната. По този начин функционалната зависимост може да се разглежда като екстремен, ограничаващ случай на най-близката вероятностна зависимост. Друг краен случай е пълната независимост на случайните променливи. Между тези два крайни случая се намират всички градации на вероятностната зависимост - от най-силната до най-слабата. Тези физични величини, които на практика считаме за функционално зависими, всъщност са свързани с много тясна вероятностна зависимост: за дадена стойност на една от тези величини, другата се колебае в толкова тесни граници, че на практика може да се счита за съвсем определена. От друга страна, тези величини, които считаме за независими на практика и в действителност, често са в някаква взаимна зависимост, но тази зависимост е толкова слаба, че за практически цели може да бъде пренебрегната.

Вероятностната зависимост между случайни променливи е много често срещана в практиката. Ако случайните величини са във вероятностна зависимост, това не означава, че с промяна на стойността стойността се променя по много определен начин; това просто означава, че когато величината се променя, величината има тенденция също да се променя (например, да се увеличава или намалява при увеличаване). Тази тенденция се наблюдава само “средно”, най-общо, като във всеки отделен случай са възможни отклонения от нея.

Помислете например за две такива случайни променливи: - височината на човек, взет на случаен принцип, - неговото тегло. Очевидно количествата и са в определена вероятностна връзка; изразява се в това, че като цяло хорататези с по-висок ръст имат повече тегло. Можете дори да създадете емпирична формула, която приблизително замества тази вероятностна зависимост с функционална. Това е например добре позната формула, която приблизително изразява връзката между височината и теглото.

Има зависими и независими събития. Две събития се наричат независими, ако настъпването на едно от тях не променя вероятността за настъпване на другото. Например, ако в един цех работят две автоматични линии, които не са свързани помежду си поради производствените условия, тогава спиранията на тези линии са независими събития.

Извикват се няколко събития колективно независими, ако някое от тях не зависи от друго събитие и от комбинация от останалите.

Събитията се наричат зависим, ако едно от тях влияе върху вероятността на другото. Например две производствени предприятия са свързани с един технологичен цикъл. Тогава вероятността от повреда на един от тях зависи от състоянието на другия. Извиква се вероятността за едно събитие B, изчислена при допускане на настъпването на друго събитие A условна вероятностсъбития B и се означават с P(A|B).

Условието за независимост на събитие B от събитие A се записва като P(B|A)=P(B), а условието за неговата зависимост като P(B|A)≠P(B).

Вероятност за събитие в тестовете на Бернули. Формула на Поасон.

Повтарящи се независими тестове, Тестове на Бернули или схема на Бернулитакива тестове се извикват, ако за всеки тест има само два резултата - възникване на събитие А или и вероятността от тези събития остава непроменена за всички тестове. Този прост дизайн на случаен опит има голямо значениев теорията на вероятностите.

Повечето известен примерТестовете на Бернули са експеримент с последователно хвърляне на правилна (симетрична и равномерна) монета, където събитие А е загубата например на „герб“ („опашки“).

Нека в някакъв експеримент вероятността за събитие А е равна на P(A)=p, тогава , където p+q=1. Нека проведем експеримента n пъти, като приемем, че отделните опити са независими, което означава, че резултатът от нито един от тях не е свързан с резултатите от предишни (или следващи) опити. Нека намерим вероятността за възникване на събития А точно k пъти, да речем само в първите k опита. Нека е събитието, че в n опита събитие А ще се появи точно k пъти в първите опити. Събитието може да се представи като

След като предположихме, че експериментите са независими, тогава

41) [страница 2]Ако зададем въпроса за появата на събитие A k пъти в n опита в случаен ред, тогава събитието може да бъде представено във формата

Броят на различните членове от дясната страна на това равенство е равен на броя на опитите от n до k, следователно вероятността от събития, които ще обозначим, е равна на

Последователността от събития образува пълна група от независими събития ![]() . Всъщност от независимостта на събитията получаваме

. Всъщност от независимостта на събитията получаваме

Когато изучавате системи от случайни променливи, винаги трябва да обръщате внимание на степента и характера на тяхната зависимост. Тази зависимост може да бъде повече или по-малко тясна.

Концепцията за независими случайни променливи е една от важните концепции на теорията на вероятностите.

Определение 1.Случайна стойност Yсе нарича независима от случайната променлива Х,ако законът за разпределение на количеството Yне зависи от това каква стойност приема количеството Х.

За непрекъснати случайни променливи, условието за независимост Yот хможе да се запише като:

Напротив, ако Yзависи от Х,Че

Нека докажем това Зависимостта или независимостта на случайните променливи винаги е взаимна:ако стойността Yне зависи от Х,след това стойността хне зависи от Y.

Наистина, нека Yне зависи от х, Тогава

Плътността на разпределение на ставите съгласно (5.4.5) и (5.4.6) може да бъде записана

откъде получаваме:

Q.E.D.

Тъй като зависимостта и независимостта на случайните променливи винаги са взаимни, можем да дадем нова дефиниция на независими случайни променливи.

Определение 2.Случайни променливи хИ Yсе наричат независими, ако законът за разпределение на всеки от тях не зависи от стойността, взета от другия. Иначе стойностите хИ Yса наречени зависим.

За независими непрекъснати случайни променливи теоремата за умножение за законите на разпределението приема формата:

тези. плътността на разпределение на система от независими случайни променливи е равна на произведението на плътностите на разпределение на отделните променливи, включени в системата.

Нека се спрем по-подробно на важните понятия „зависимост“ и „независимост“ на случайните променливи.

Концепцията за „зависимост“ на случайни променливи, която използваме в теорията на вероятностите, е малко по-различна от обичайната концепция за „зависимост“ на променливите, която използваме в математиката. Наистина, обикновено под „зависимост” на величините разбираме само един вид зависимост – пълна, твърда, т.нар. функционаленпристрастяване. Две количества хИ Yсе наричат функционално зависими, ако, знаейки стойността на един от тях, можете точно да посочите стойността на другия.

В теорията на вероятностите се сблъскваме с друг, по-общ вид зависимост - с вероятностенили "стохастична" зависимост. Ако стойността Yсвързани с величината хвероятностна зависимост, тогава, знаейки стойността Х,невъзможно е да се посочи точната стойност Y,но можете само да посочите неговия закон на разпределение, в зависимост от това каква стойност приема количеството Х.

Вероятностната зависимост между случайни променливи е много често срещана в практиката. Ако случайни променливи хИ Yса във вероятностна връзка, това не означава, че с промяна на стойността хвеличина Yпромени по много специфичен начин; това означава само, че с промяна в стойността хвеличина Yима тенденция също да се променя (например да се увеличава или намалява с увеличаване Х).

Помислете например за две такива случайни променливи: х- височина на произволно взет човек, Y- теглото му. Очевидно количествата хИ Yса в определена вероятностна връзка; изразява се в това, че като цяло хората с по-висок ръст имат повече тегло.